Содержание:

Современному человеку повезло наблюдать, как стремительно развиваются технологии, меняя мир вокруг нас. Ярчайшим примером тому является развитие нейросетей — систем искусственного интеллекта, имитирующих работу человеческого мозга и нервной системы.

Благодаря упорной работе учёных над созданием машин, которые умеют решать сложные задачи и адаптироваться к изменяющимся условиям, успехам в области нейрофизиологии, нейроанатомии и психологии, а также интеграции достижений в различных науках, то, о чём раньше писали фантасты, сегодня становится реальностью. С каждым годом нейросети становятся всё более мощными, эффективными и находят применение в разных отраслях, решая задачи, не так давно казавшиеся непосильными.

Не будем погружаться в глубину веков, рассуждая на тему вклада древних учёных в формирование научно-философского мировоззрения, а обратимся непосредственно к истокам развития нейросетей. В эволюции искусственного интеллекта нейросетевые технологии стали одним из самых значительных достижений, пройдя долгий путь развития от простых моделей до более сложных архитектур, способных решать множество задач.

Концепция нейросетей зародилась ещё в прошлом веке, когда учёные активно занялись изучением возможности создания искусственного интеллекта. В 1936 году Алан Тьюринг предложил идею, ставшую базисом для информатики и описывающую абстрактную вычислительную машину, известную как машина Тьюринга. Это изобретение способно решить любую задачу при наличии алгоритма её решения.

В 1943 году нейрофизиологи Уоррен Мак-Каллок и Уолтер Питтс представили математическую модель работы нейронов (известную как модель Мак-Каллока-Питтса), созданную на основе изучения биологических процессов и объясняющую механизмы обработки информации нервной системой. Эта работа стала ключевым элементом в развитии искусственного интеллекта, первых нейронных систем и нейрокомпьютеров.

В 1949 году свет увидела работа «Организация поведения», автором которой стал нейропсихолог Дональд Хебб. В ней учёным была предложена идея, что процесс обучения связан с изменением силы синаптических связей между нейронами, а также сформулировано утверждение: «Если два нейрона неоднократно активируются одновременно, связи между ними усиливаются в обоих направлениях». Это правило впоследствии послужило основой для многих моделей обучения искусственных нейросетей, включая перцептрон Ф. Розенблатта.

В 1950 году Тьюрингом опубликована работа «Вычислительные машины и разум», в которой описывается концепция «имитационной игры» (тест Тьюринга). Тестирование служит инструментом для определения наличия разума у машин. Некоторые современные машины успешно имитируют поведение человека и способны пройти тест Тьюринга, хотя этот факт больше говорит об устаревании метода тестирования, чем о разумности чат-ботов.

В 1957 году американский учёный Фрэнк Розенблатт разработал первую искусственную нейронную сеть, получившую название «персептрон». Созданная на базе модели биологического нейрона, она обучалась на основе входных данных и позволяла распознавать образы, а также выполнять другие простые задачи, связанные с обработкой информации.

Нейрон перцептрона, в отличие от нейрона Мак-Каллока и Питтса, имеет веса синапсов — числовые значения. Персептрон состоит из трёх основных слоёв: входного (сенсорного), скрытого (ассоциативного) и выходного (реагирующего). Передача сигналов от датчиков ассоциативным элементам, а затем реагирующим элементам позволяет создавать набор «ассоциаций» между входными стимулами и нужной реакцией на выходе, что сродни преобразованию информации (например, зрительной) в физиологический ответ от двигательных нейронов человеческого мозга.

Ряд экспериментов показал, что сеть способна успешно распознавать простые образы, такие как буквы и цифры, но вместе с этим выявились и ограничения. Перцептрон не мог обрабатывать сложные функции, так как может решать только линейно разделимые задачи и имел проблемы с обучением.

Первая версия моделировалась посредством компьютера IBM 704, затем аппаратным воплощением в 1960 году стал первый в мире нейрокомпьюютер Mark I Perceptron. Математическая модель Розенблатта, имитирующая процесс восприятия информации мозгом, хотя и имела ряд недостатков, стала прообразом более сложных и эффективных нейронных сетей, используемых в современных компьютерах и системах управления.

В 1960-х годах активность развития нейросетей снизилась из-за популярности других способов машинного обучения.

В 1963 году Леонард Юр и Чарльз Восслер создали алгоритм, позволяющий анализировать и интерпретировать графические изображения, закодированные в виде таблиц с нулями и единицами. Программа могла выявлять и анализировать различные характеристики и особенности изображений, создавая уникальные паттерны для каждого из них, что стало преодолением ограничений простых персептронов. Так, работа стала прообразом свёрточных нейронных сетей, появившихся уже в конце 80-х.

В 1966 году был разработан первый чат-бот ELIZA, использовавший ИИ для ответов на вопросы пользователей. ELIZA умела имитировать беседу с человеком, применяя техники и методы обработки естественного языка.

Следующий этап развития знаменуется появлением в 80-х годах искусственных нейронных сетей (ANN), которые были мощнее и гибче чем персептроны, а также могли решать более сложные задачи (распознавание речи, изображений и пр.).

Реализация новых алгоритмов обучения, таких как обратное распространение ошибки, позволила сетям обучаться на больших объёмах данных, значительно повысив эффективность. Хотя мощности и не было достаточно для решения сложных задач, интерес к нейросетям вернулся.

Значительный вклад в развитие нейронных сетей и глубокого обучения внёс канадский учёный Джеффри Хинтон, известный как «отец искусственного интеллекта». Реализованный профессором совместно с коллегами из Университета Торонто алгоритм обратного распространения ошибки, позволяющий обучать многослойные персептроны, широко применяется и сегодня. Работа Хинтона также включает исследования по обучению с подкреплением, аппроксимации функций и другим темам, касающимся ИИ.

В конце 80-х — начале 1990-х в ходе изучений в области компьютерного зрения были созданы свёрточные нейронные сети. Основной принцип таких нейросетей был предложен Яном Лекуном и заключается в использовании операций свёртки для обработки входных данных и выделения значимых признаков. Свёрточные слои применяют фильтры для выполнения операции свёртки на входе, благодаря чему процесс выявления основных особенностей изображения автоматизируется.

Перемещаясь по всей входной картинке, фильтры выполняют процедуру свёртки, выявляя присутствие и степень значимости характеристик на изображении. В ходе обучения нейронной сети выполняется также оптимизация и обучение фильтров для выявления признаков, использующихся далее в следующих слоях для классификации информации или иных задач.

Лекун и его коллеги первыми применили свёрточные нейронные сети для определения рукописных цифр в базе данных MNIST. Этот тип сетей стал наиболее удачным вариантом благодаря способности к обучению и обобщению данных, что сделало его основным инструментом в области компьютерного зрения и глубокого обучения. Применение свёрточных сетей распространилось и на множество других задач.

Алгоритмы глубокого обучения, позволяющие разрабатывать многослойные нейросети, стали активно развиваться в начале 2000-х и улучшили способность нейронных сетей к решению сложных задач. Точность и эффективность значительно повысились с развитием технологий и увеличением объёма данных. Такие компании, как Google, Facebook и Microsoft, начали применять нейросети в программном обеспечении и сервисах.

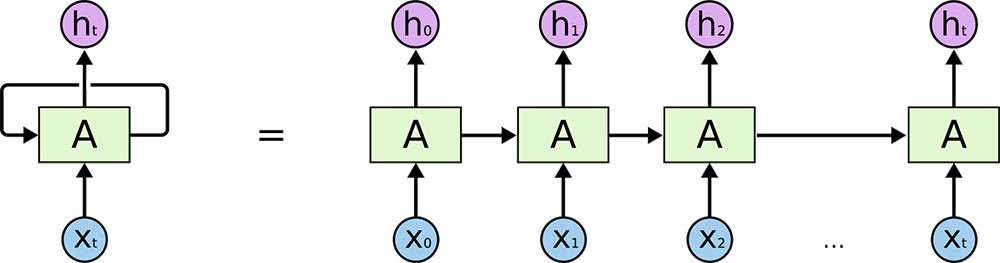

Фрагмент нейронной сети A принимает входное значение x и возвращает значение h

Кроме свёрточных (CNN), использующих операции свёртки для извлечения значимых признаков из изображений, данный период включает и появление других типов сетей, таких как рекуррентные нейронные сети (RNN) и глубокие нейронные сети (DNN).

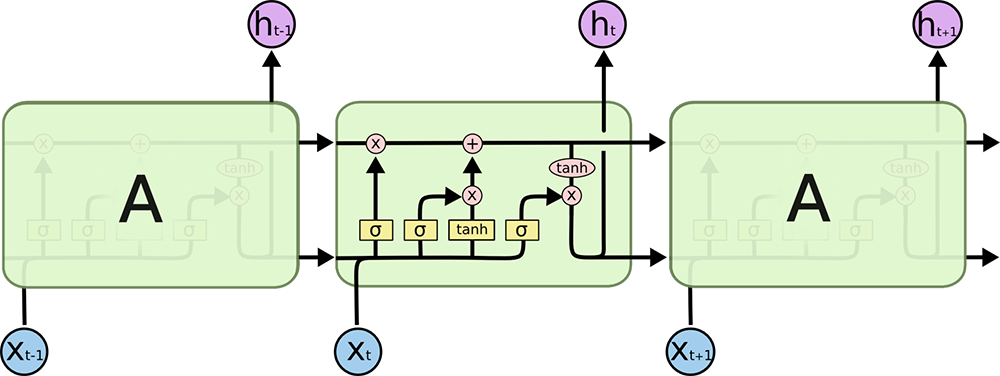

В 1997 Зеппом Хохрайтером и Юргеном Шмидхубером была представлена рекуррентная нейросеть LSTM, способная обрабатывать последовательности данных. В этом же году программа Deep Blue, созданная IBM, смогла выиграть у чемпиона мира Гарри Каспарова (первый случай, когда компьютер обыграл человека в шахматы, был зафиксирован ещё в 1972 году). Deep Blue применяла нейронные сети для прохождения обучения и анализа позиций на доске, что обеспечивало принятие решений, похожих на решения человека.

Схема рекуррентной нейросети LSTM

Рекуррентные нейросети стали основой для обработки последовательностей данных (текст, речь и временные ряды). Их отличие в сохранении информации на протяжении всего процесса обработки, благодаря чему данные обрабатываются в правильном порядке.

В последнее время можно наблюдать рост популярности глубокого обучения, включающего в себя использование нескольких уровней нейронной сети. Стремительным развитием глубокие нейросети обязаны графическим процессорам (GPU), позволяющим ускорить их обучение.

Популярность нейросетей значительно выросла с развитием технологий и увеличением производительности компьютеров. Искусственный интеллект и машинное обучение проникают во все сферы жизни человека, а нейронные сети становятся базисом многих современных технологий.

В 2012 году компания Google представила нейросеть «Google Brain», которая применяла алгоритм глубокого обучения для обработки больших объёмов данных. Сети глубокого обучения используют несколько уровней для обработки входной информации, эти слои могут состоять из различных типов нейронов (сигмоидальные, радиальные базисные функции или тангенциальные функции).

Важным шагом в развитии компьютерного зрения в 2012 году стала победа нейросети AlexNet в соревновании по классификации изображений ImageNet. Это доказывает, что использование нейронных сетей может существенно повысить точность и эффективность обработки картинки в сравнении с другими методами.

В 2014 году были разработаны генеративные состязательные сети (GANs), состоящие из двух нейронных сетей: генератора, генерирующего вероятные решения, и дискриминатора, оценивающего их. Сети GANs способны создавать новые примеры, аналогичные обучающим данным, они могут также применяться в задачах обработки изображений, таких как улучшение качества картинки или наложение эффектов.

В 2015 году компанией Facebook была представлена нейросеть «DeepFace», позволяющая идентифицировать лица на фото с высокой точностью. В этом же году Microsoft выпустила нейронную сеть «Microsoft Cognitive Toolkit», обеспечивающую распознавание речи и изображений.

В этом же году компания Google разработала нейросеть «TensorFlow», в 2016-м Nvidia создала библиотеку для работы с ней. Фреймворк стал одним из самых популярных инструментов для работы с нейросетями. Посредством TensorFlow можно создавать сложные модели, которые способны работать с большими объёмами данных.

В 2016 году созданная Google DeepMind сеть AlphaGo победила чемпиона мира по игре в го Ли Седоля, применяя свёрточные нейронные сети для обработки изображений доски и предугадывания возможных ходов, а также рекуррентные сети для запоминания сделанных ходов и принятия решений, основываясь на данной информации.

В 2017 году DeepMind представила AlphaZero (усовершенствованная версия алгоритма AlphaGo), которая смогла одержать победу в играх шахматы, сёги и го против чемпионов мира. Программа AlphaZero обучается играть самостоятельно, без вмешательства человека, используя алгоритмы машинного обучения для анализа позиций на доске и принятия решений.

В 2017 году Google опубликовал работу, в которой была представлена концепция трансформеров, базирующихся на механизме внимания для обработки информации. Её популярность привела к развитию многих других технологий в сфере искусственного интеллекта.

Уже в следующем году OpenAI выпускает первую версию GPT — большую языковую модель, использующую архитектуру трансформер для генерации текста.

Сегодня нейросети применяются в различных областях (медицина, финансы, транспорт, промышленность и многие другие), помогая в принятии решений и улучшая качество жизни, а также эффективность работы различных систем.

В 2020 году компанией OpenAI представлена нейросеть GPT3, ставшая одной из самых мощных в мире. Она использует архитектуру трансформера, позволяющую обрабатывать большие объёмы данных и генерировать длинные тексты на разных языках, отвечать на вопросы и выполнять множество других задач.

Ещё одна нейросеть, представленная также в 2020 году компанией DeepMind, показала поразительные результаты определения трёхмерной структуры белка. Программа AlphaFold, обучаясь на большом количестве известных структур белков и используя эти сведения для предсказания структуры новых белков, успешно предсказала десятки тысяч белков, что может иметь большое значение для науки и медицины.

Нейросети также активно используются для создания голосовых помощников, обеспечивающих взаимодействие пользователя с компьютером или смартфоном в виде общения на естественном языке с возможностью получения ответов на вопросы.

В 2021 году компания Nvidia представила новую версию своей платформы для работы с нейронными сетями — NVIDIA NGC Cloud. Площадка открывает доступ к различным моделям нейросетей и инструментам для их обучения и развёртывания.

В 2022 году компания Яндекс предложила собственную платформу для работы с нейросетями — Яндекс.NLP. Она позволяет работать с различными типами нейронных сетей и большими объёмами данных, благодаря чему можно создавать более точные модели.

В 2023 году OpenAI выпустила новую версию GPT-4, разработанную с применением последних достижений в области искусственного интеллекта и машинного обучения, за счёт чего нейросеть стала ещё более мощной и продвинутой. Кроме того, GPT-4 стала более доступной для пользователей, программа даже не требует установки на устройство.

В настоящее время нейросети, прошедшие путь от первых примитивных моделей до современных глубоких нейронных сетей, продолжают развиваться и совершенствоваться с невероятной скоростью, позволяя решать задачи высокой сложности, и находят применение в самых разных областях деятельности человека.